在现代数据驱动的时代,越来越多的企业和开发者开始关注如何利用国外服务器来处理海量的大数据。无论是进行数据分析、机器学习还是大规模存储,国外服务器凭借其高效的网络架构、丰富的计算资源以及灵活的扩展性,成为大数据处理的重要工具。本文将详细阐述如何利用国外服务器实现高效的大数据处理,并结合实战教程帮助开发者更好地完成这一任务。

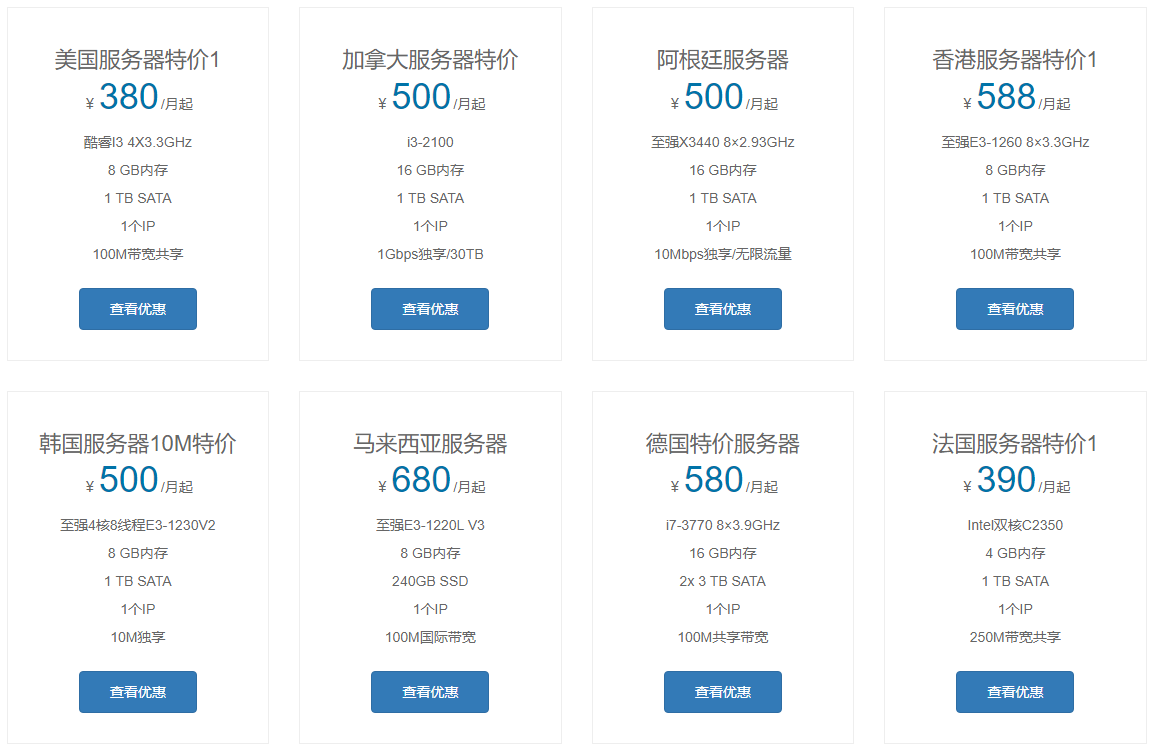

国外服务器为您在国外外贸业务开展提供技术支持服务,24小时技术咨询热线400-808-5836,微信号fobhostcom。选择合适的国外服务器是大数据处理成功的关键。国外服务器通常具备更高的带宽、更低的延迟以及更灵活的资源分配,适用于数据量大、计算要求高的应用场景。在选择时,用户首先需要关注服务器的网络连接稳定性。优质的国外数据中心通常拥有多个冗余网络连接,并提供更高的带宽,使得数据传输更加稳定迅速。其次,硬件配置的强大也是评估服务器性能的重要标准。强大的CPU、足够的内存和大容量硬盘是支持大数据处理任务顺利进行的基础。

大数据处理通常涉及多个技术栈与工具。首先,数据存储是大数据处理的基础,Hadoop分布式文件系统(HDFS)是常见的存储工具。HDFS能够将海量数据切分成小块,分布存储在多台服务器上,具备高容错性和可扩展性。其次,在数据处理方面,Apache Spark是目前使用广泛的计算框架。相比Hadoop MapReduce,Spark提供了更高的计算效率,尤其在内存计算方面表现突出,适用于需要实时分析的业务场景。

在国外服务器上部署大数据平台时,首先需要选择合适的操作系统和虚拟化平台。Linux是大数据处理最常用的操作系统,它稳定且支持广泛的开源大数据工具。如果需要灵活的资源分配和更高的运行效率,可以考虑使用Docker等容器化技术。在此基础上,用户可以安装大数据框架(如Hadoop、Spark等)并进行配置。部署时,要合理划分节点角色,通常需要配置多个计算节点和存储节点,以提升系统的处理能力和容错能力。

在实际操作中,优化数据处理流程对于提升整体性能至关重要。首先,优化数据存储结构非常重要。采用列式存储(如Parquet、ORC)可以提高数据的读写效率,尤其适合分析型查询。其次,针对数据处理任务,合理分配资源也能提升效率。Spark等框架提供了灵活的资源管理机制,可以根据任务需求调整计算资源。最后,分布式计算模型的设计也非常关键。将计算任务合理划分成多个小任务,充分利用多台服务器的计算能力,可以大幅提升数据处理速度。

以下是一个典型的大数据处理案例。在某电商平台,企业需要分析大量用户行为数据,以便进行精准营销。首先,他们选择了AWS(亚马逊Web服务)提供的国外服务器。利用AWS EC2实例作为计算节点,结合S3存储系统作为数据存储,建立了一个分布式大数据处理平台。随后,使用Apache Spark进行数据处理,结合Hadoop进行存储管理,最终将处理结果存入数据库中供后续分析使用。通过这种方式,电商平台能够快速处理海量数据,并实现实时的数据分析和决策支持。

在使用国外服务器处理大数据时,开发者常常遇到一些挑战。首先是跨境数据传输的延迟问题。解决此问题的一个方法是选择离数据源较近的服务器,减少传输时间。其次,数据的安全性也是一个关键问题。通过加密传输和使用私有云,能够有效提升数据的安全性。最后,成本管理也是一个不可忽视的问题。选择合适的计费模式(如按需付费或包年包月)并合理分配资源,可以降低服务器使用成本。

总的来说,利用国外服务器进行大数据处理,不仅能够提供强大的计算和存储能力,还能有效优化数据处理流程,提升分析效率。在实际操作中,选择合适的技术栈、合理配置硬件资源、优化数据存储和计算流程,都是提升性能的关键。随着大数据技术的不断发展,未来大数据处理将变得更加高效和智能,企业也能通过这些先进的技术实现更精准的数据分析与决策支持。

租用服务器就找国外服务器租用平台https://www.fobhost.com/,24小时技术咨询热线400-808-5836,微信号fobhostcom。